如禁信息采集器采集信息?

信息采集器 可以轻松获取网站的数据,有什么办法可以不让它采集本网站吗?又不影响搜索引擎搜索本网站。还要不能影响本网站的性能。 --------------------编程问答-------------------- up --------------------编程问答-------------------- 这个议题不错,既能防止采集又不能影响搜索引擎收录。我认为可以先列举出一些防止采集的手段。然后看看在这些手段中,如何优化。

最好先分析分析采集程序的运行原理。不过采集软件很多种,肯定都有各自的特别之处。 --------------------编程问答-------------------- 常用的采集软件通过分析源码,人为定义规则,过滤html,截取有用信息。

那么如果源码中没有全部信息,只保留一段最主要的介绍给搜索引擎爬,然后ajax调用全部内容显示在页面上。这时的源码肯定没有全部的内容。再在ajax调用的页面中,加入检测访问来源的过滤。数据读取装入cache。

一个设想,抛砖引玉... --------------------编程问答-------------------- 好像 楼上那个方法不得行啊 用 curl 照样可以把信息读出来啊

--------------------编程问答--------------------

你可以记录这类访问的ip,如果它不在一定的范围内(这个通常依据一个内存中的“白名单”数据库进行判断),就可以Hang它一段时间再回应。 --------------------编程问答--------------------

想法不错,呵呵 --------------------编程问答--------------------

有用的内容如果不给搜索引擎,那么搜索引擎还能用来干什么? --------------------编程问答--------------------

如果是拨号上网就不太好控制了,要是他设置十分钟自动断线,再链接。就防不住他了。 --------------------编程问答--------------------

只保留一段最主要的介绍给搜索引擎爬

应该能够让蜘蛛有所收获的回去吧。 --------------------编程问答--------------------

在此表达一下我对你的崇拜之情~

我知道你用cache很厉害。理解很深刻。请多指教呀! --------------------编程问答-------------------- 什么叫curl? --------------------编程问答-------------------- 觉得目前最好的办法还是把ip地址禁止掉 --------------------编程问答--------------------

要想采集,我不只可以用拨号网络,也可以更换不同的代理。所以禁ip还不是最好的办法。 --------------------编程问答-------------------- 矛与盾,呵呵 IP控制 --------------------编程问答-------------------- robots 规则怎么解决? --------------------编程问答--------------------

这种怎么生成静态 不生成静态 好象不能被baidu收录啊 --------------------编程问答-------------------- 自己辛辛苦苦的东西给人采集回去.真的是恼火哦 --------------------编程问答--------------------

有效防止蜘蛛采集?蜘蛛使用代理采集呢?

如果蜘蛛被网站所禁了IP无法采集,那蜘蛛只能转换成代理去采集,你如何防止?

百度,google的爬虫徘徊在你的网站上采集,你也把他们禁止了?那如何搜索你的网站。

这是个矛盾的问题。

--------------------编程问答--------------------

生成静态照样可以,只不过通过ajax调用相关信息。而且也可以用urlrewriter实现。 --------------------编程问答-------------------- 不大会有这好的事哦 --------------------编程问答-------------------- 达梦通用网页采集器

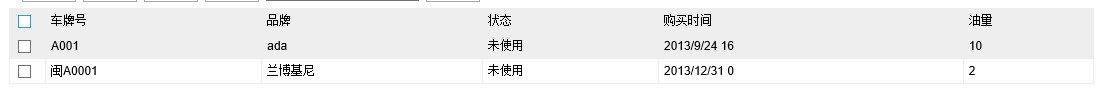

如果您已经有了一个某类似信息的专业网站,但数据量还不足,想让百度收集您几百万的页面,数据量从哪来呢,自己去添加肯定不现实,达梦CMS系统专用采集器,可以帮您解决这个问题。专门针对目前流行的几大CMS系统,如php168、帝国CMS等,您只需要指明从哪些网站采集信息,并指明您网站CMS系统的mysql帐号,如果不能提供mysql帐号,可以采用达梦公司提供的php文件,然后您设置定时采集时间或手动采集。该采集器会自动从对方网站提供网页正文和标题,并能自动为您进行文章分类。您建一个新闻系统还困难吗,各大网站的新闻自动到您的数据库,且是最新的。

达梦网页采集器是一个功能强大的数据采集软件.使用它,您可以很容易的从网页上抓取文字,图片,文件等资源.程序支持远程下载图片文件,并生成缩略图,支持网站登陆后信息采集,支持探测文件真实地址,支持代理设置,支持防盗链的采集,支持采集数据直接入库和模仿人手工发布等。同时,软件具有极高的稳定性,可以多线程,多任务的工作,您可以用它进行大批量数据的更新。程序还支持多页和分页的采集,支持数据跨页采集,再难的数据格式也可以找到解决方案。采集器可以运行在windows和linux平台。

软件应用范围:

1.网站采编人员:打破传统的采编人员必须手工转载文章的现状,使他们更有时间去做数据的编辑加工,工作更有成效.程序可以完美结合TRS等采编系统,大型网站的信息采集将更加容易有效。常用于新闻采集、论坛采集、技术文章采集。

2.内部网络:打破内网信息单一,获取困难的神话,内部网络也可以体验丰富多彩的互联网信息.可以解决形如军队等与因特网隔离的重要部门对于因特网的信息需求问题。

3.政府机关:实时跟踪、采集与政府工作相关的国内外及地方新闻,政策法规,经济,产业等信息,解决政府主网站对各地级子网站的信息采集与整合问题.

4.企业应用:实时而准确地采集国内外新闻,行业新闻,技术文章.可以很容易的进行数据整合,情报处理更快捷高效,大大减少业务成本。将不同系统不同结构的数据统一成相同的格式。

5.SEO人员或站长:数据的获得更加容易,可迅速增加网站信息量,可以将更多精力放在优化和推广上。

达梦采集器特有的功能:

1.支持所有编码格式的数据采集,自动识别编码,您可以用它采集全世界的文章.程序还可以进行编辑间的完美转换。

2.多接口:支持所有主流或非主流的CMS,BBS,下载站,ftp等,您可以通过系统的接口实现采集器和网站的完美结合.

3.无人值守工作:您配置好程序以后,程序就可以按照您的设置自动运行,完全不需要人工干预。

4.本地编辑采集数据:您可以在本地可视化编辑已采集的数据.

5.采集内容测试功能:这是其它任何采集软件所不能比的,可直接查看结果并测试发布。

6.管理方便:使用站点+任务方式管理采集节点,任务支持批量操作,再多的数据管理也很轻松。灵活的管理后台设定。

联系电话:020-22174900,传真:020-28315847 联系QQ:46244150 联系网址:达梦科技

--------------------编程问答-------------------- 可以肯定这是不可能做到的

你无法区别采集器和搜索蜘蛛,因为采集可以模仿蜘蛛抓取,你根本无法区分

唯一的办法只能是根据采集器爬行的速度进行相关控制,一般大型网站的做法是,一个IP访问太过频繁就会在X分站内自动禁止其访问。但如果采集器使用单线程采集那什么办法都没有 --------------------编程问答-------------------- 另外使用AJAX也并不能完全禁止采集,Google就能处理抓取AJAX调用的数据

其原理无非是进一步分析JS就可以得到相关数据

想使搜索引擎正常收录又能禁止采集,可以把部分正文FLASH或图片处理,这样包括搜索引擎在内的任何采集器只能分析其中部分HTML,想看完整的文章只能去你的网站

补充:.NET技术 , ASP.NET