求openstack、hadoop和磁盘阵列共存的解决方案

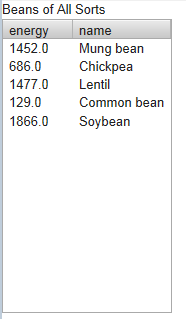

目前项目环境搭建需要openstack和hadoop环境,openstack负责分配不同虚拟镜像,hadoop主要负责数据存储和将来mapreduce的计算。网络环境有32台服务器,一个磁盘阵列,要求提供高速文件访问和在不同虚拟机环境下的并行计算。请有经验的行家给个合理的解决方案。自己的一些想法:

1、看到Savanna project的基本思路是把hadoop架设在openstack上,应该是利用openstack灵活分配虚拟镜像的能力,定制Name Node 、Data Node等节点镜像,然后由openstack负责根据用户指定规模和拓扑分配hadoop的分布式集群,但我不需要这么灵活,只要有一个hadoop集群就够了,那么将hadoop架设在openstack上的难度有哪些?会不会因为增加了openstack对虚拟镜像的管理而导致HDFS文件系统的性能受损?

2、在网上看到这种解决方案“在私有云环境中,常见的大数据部署模型之一是:将 OpenStack 的 Swift 存储技术部署到 Apache Hadoop MapReduce 集群,从而实现处理功能。”如果按这个思路,应该是openstack和hadoop分别部署,把openstack的swift部署到hadoop集群,那么在部署时将swift部署到磁盘阵列和hadoop集群有何区别,有何困难?

3、1或2的两个方案哪个更可行?如何使openstack和hadoop充分利用磁盘阵列的存储资源? Hadoop OpenStack 存储 集群 --------------------编程问答-------------------- 楼主现在找到切实可行的方案没?我现在也处于跟你类似的阶段,anbo724@gmail.com希望可以讨论一下 --------------------编程问答-------------------- 云计算很多东西需要继续研究

补充:云计算 , OpenStack