当前位置:站长资源库 > 服务器教程 >>

- 最新服务器学习:

Nginx只允许百度谷歌等搜索引擎蜘蛛访问方法

[Nginx]只允许百度谷歌等搜索引擎蜘蛛访问,正常用户无法访问,ua头根据自身情况进行增加删减在nginx的server字段中配置下面内容即可set$yizuotu0;if($http_user_agent~*(Baiduspider|google宝塔面板停止网站页面修改路径

[Nginx]其实,修改这个提示很容易,我们只需要在宝塔文件里找到:/www/server/stop/index.html进行修改就行了!宝塔面板“抱歉,站点已暂停”提示页面的修改宝塔面板停止网站页面修改路径因为特殊需求需要更改“抱歉!该站点已经被管Web服务图片压缩,nginx+lua生成缩略图

[Nginx]目前而言,用移动端访问Web站点的用户越来越多,图片对流量的消耗是比较大的,之前一个用户用我们网站的app浏览的时候,2个小时耗去了2个G的流量,这是个很严重的问题,需要对图片进行压缩,减少对用户带宽的损耗。方法用户访问网站,上传图片,nginx+lua 生成缩略图 核心代码

[Nginx]访问缩略图修改nginx.conf文件:server{listen80;senginx和lua 安装lua实现编程

[Nginx]lua作为嵌入式脚本,在目前所有的脚本引擎中速度是最快的。它由标准C编写而成,几乎在所有操作系统和平台都可以编译运行。我们为什么要用nginx+lua呢?我们来比较下nginx+lua和nginx+php:nginx+php之间是要有进nginx+lua防采集

[Nginx]之前介绍了nginx+lua+redis实现验证码防采集,在此基础上我又增加了搜索引擎的域名反查,以排查伪造搜索引擎的爬虫。原理是查看根据useragent为搜索引擎的客户端,如:百度、搜狗、谷歌等;通过nslookup或其他工具反查其

nginx+lua+redis实现验证码防采集

[Nginx]之前介绍过在nginx里如何嵌入lua模块,利用nginx+lua可以很好的开发开发nginx的业务逻辑,并且达到高并发的效果。下面我们就来介绍下利用nginx+lua+redis实现防采集的功能。现象:网站在为用户提供服务的同时也在被the listen ... http2 directive is deprecated, use the http2 directive instead in

[Nginx]在nginx遇到错误[warn]the\\\\\\\"listen...http2\\\\\\\"directiveisdeprecated,usethe\\\\\\\"http2\\\\\\\"directiveinstead在1.2apache屏蔽蜘蛛 下方代码复制到.htaccess文件

[Apache]根据需要调整垃圾蜘蛛名称:<IfModulemod_rewrite.c>RewriteEngineOn#BlockspiderRewriteCond%{HTTP_USER_AGENT}\"SemrushBotiis 10屏蔽垃圾蜘蛛 web.config

[IIS]根据需要调整蜘蛛名称:<?xmlversion=\"1.0\"encoding=\"UTF-8\"?><configuration><systemnginx禁止垃圾蜘蛛访问

[Nginx]现在很多ai蜘蛛,大数据蜘蛛,天天偷偷抓取网站信息,不给流量也罢。关键是没底线:来了就不走,一直反复抓取,浪费大量服务器资源,如果您有需要,立刻屏蔽吧:/zzzyk.com/nginx/conf文件夹下建立zzzyk_deny.confnginx 禁止访问目录 nginx禁止访问文件配置方法

[Nginx]Nginx默认是不允许列出整个目录的。如需此功能,打开nginx.conf文件或你要启用目录浏览虚拟主机的配置文件,在locationserver或http段中加入autoindexon;另外两个参数最好也加上去:autoindex_e

最新图片服务器教程:

IIS7下配置跨域设置Access-Control-Allow-Origin

通过系统自带计划任务,实现电脑服务器自动重启设置图文教程

分享Windows下安装Sphinx的方法和步骤

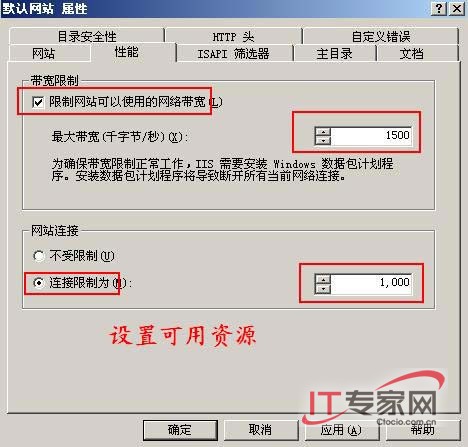

IIS6易做图访问流量的方法以及带宽介绍

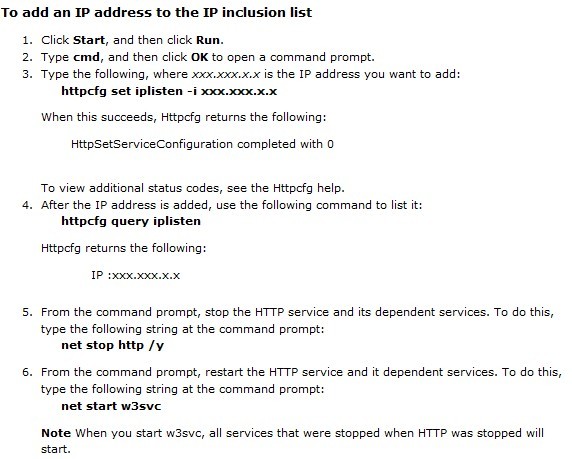

让IIS和Apache共同使用80端口的方法

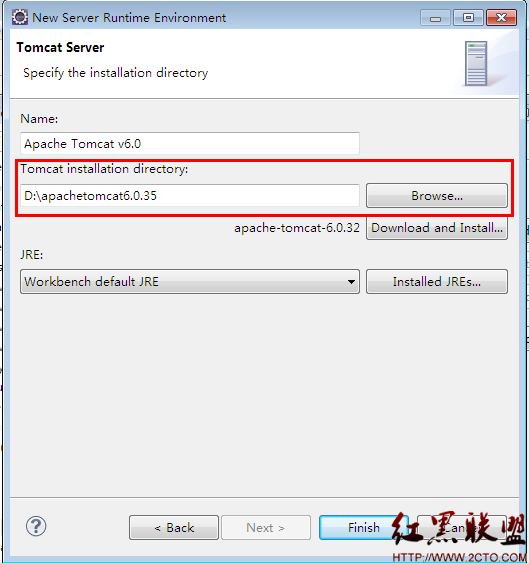

Java EE IDE Eclipse 配置Tomcat

WindowsServer2003R2、IIS6下由于Session会乱串__导致系统无易做图常使用

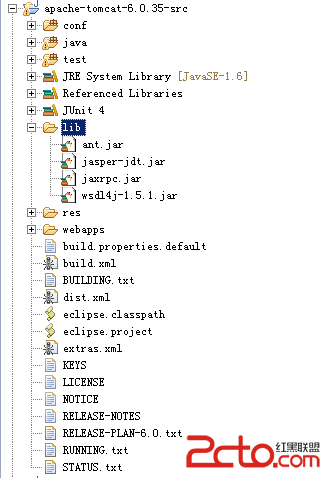

Eclipse导入Tomcat源代码

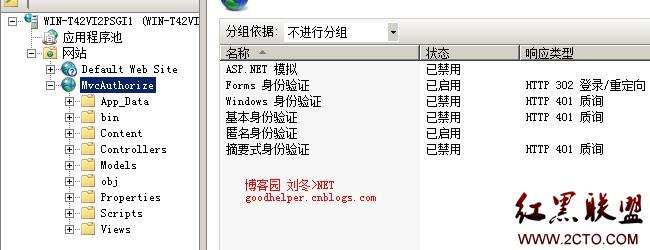

Android与IIS身份验证——Form验证

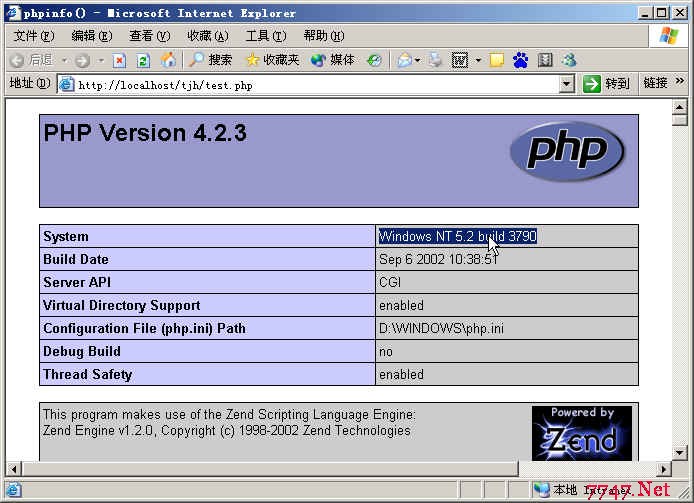

PHP 在Windows 2003 Enterprise Server 、IIS6.0 下的安装

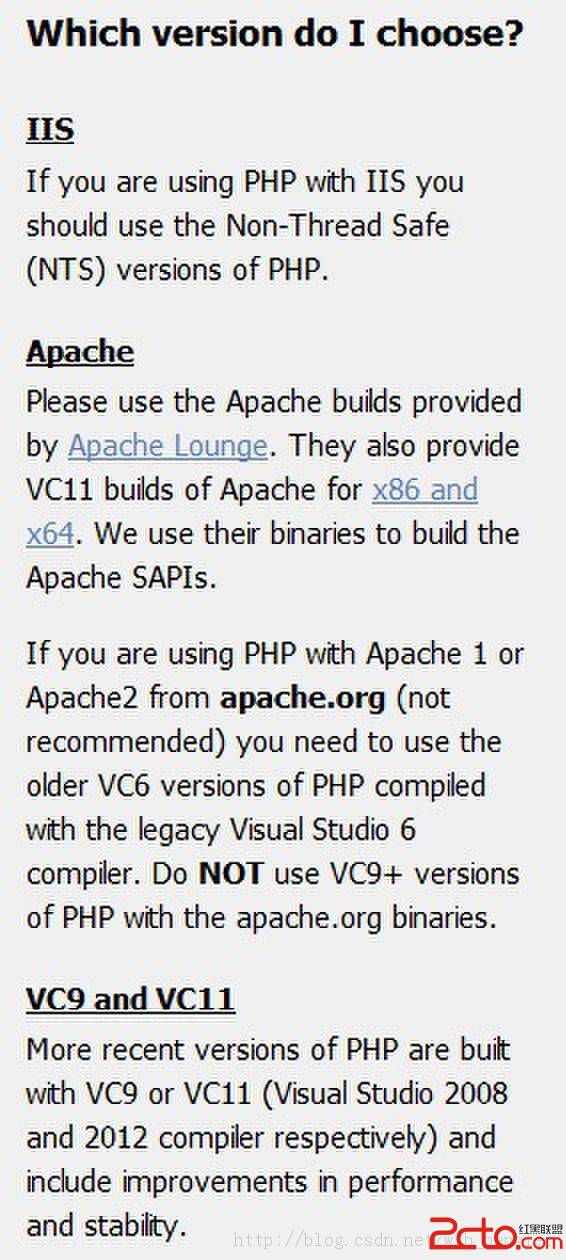

在Windows中安装Apache2和PHP4的权威指南

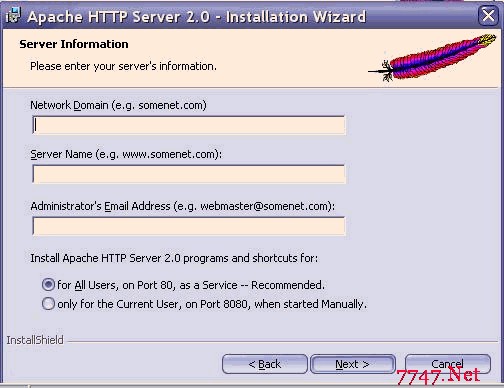

php-5.3+APACHE 安装配置

- 最新服务器学习信息:

- Nginx只允许百度谷歌等搜索引擎蜘蛛访问方法

- 宝塔面板停止网站页面修改路径

- Web服务图片压缩,nginx+lua生成缩略图

- nginx+lua 生成缩略图 核心代码

- nginx和lua 安装lua实现编程

- nginx+lua防采集

- nginx+lua+redis实现验证码防采集

- the listen ... http2 directive is deprecated, use the http2 directive instead in

- apache屏蔽蜘蛛 下方代码复制到.htaccess文件

- iis 10屏蔽垃圾蜘蛛 web.config

- nginx禁止垃圾蜘蛛访问

- nginx 禁止访问目录 nginx禁止访问文件配置方法

- nginxweb服务器 禁止垃圾搜索引擎爬虫访问网站的方法

- Lnmp 网站根目录文件权限

- nginx出现413 Request Entity Too Large问题的解决方法

- 如果你遇到编程难题:

访问站长资源库:www.zzzyk.com

最近更新:2025-07-31 15:22:04